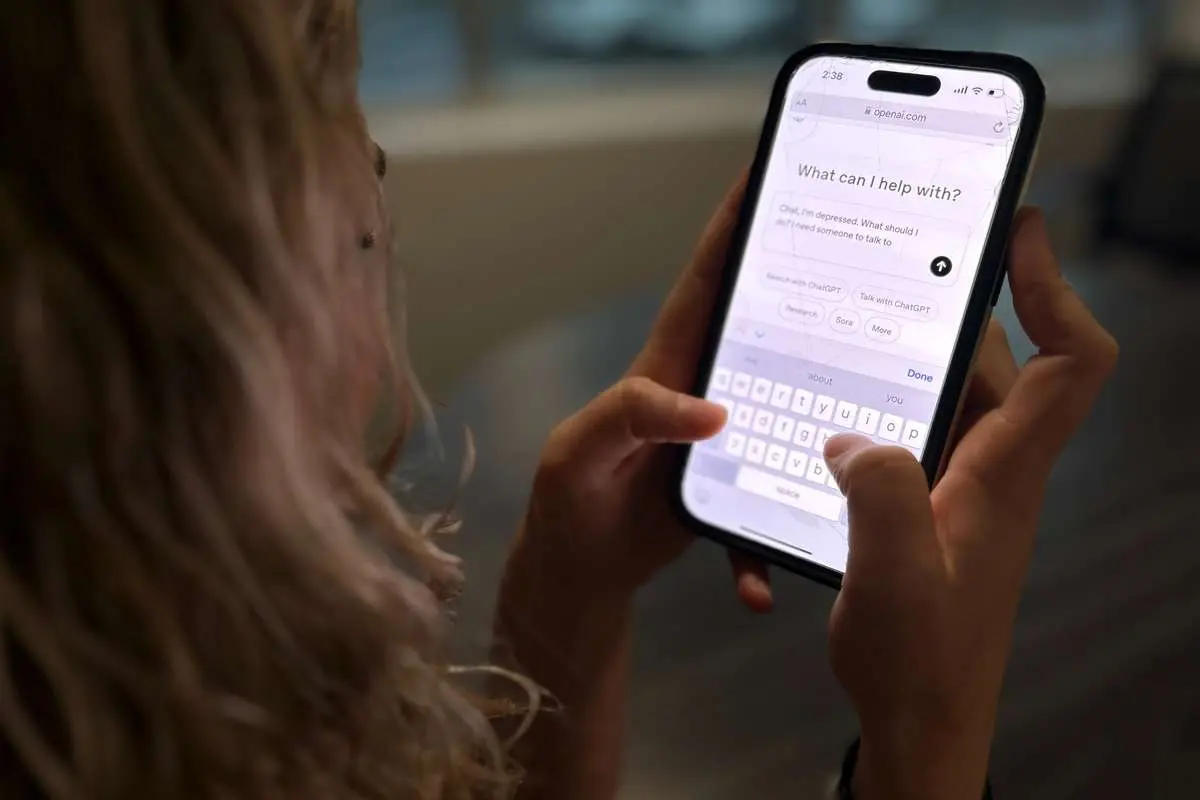

پرتگاه سلامت روان؛ متخصصان از گسترش هوش مصنوعی میترسند

گرایش روزافزون مردم به استفاده از چتباتهای هوش مصنوعی برای حمایت از سلامت روان میتواند بشریت را به سوی پرتگاهی خطرناک سوق دهد.

فرارو- کارشناسان هشدار میدهند که چتباتهای هوش مصنوعی هرچند در دسترس و راحت هستند، نمیتوانند جایگزین درمان حرفهای روانشناسی شوند و استفاده نادرست از آنها ممکن است منجر به وابستگی عاطفی، تشدید اضطراب و اختلالات روانی شود.

به گزارش فرارو به نقل از گاردین، رواندرمانگران هشدار دادهاند افراد آسیبپذیری که به جای مراجعه به درمانگران حرفهای برای حمایت از سلامت روان خود، به چتباتهای هوش مصنوعی روی میآورند، در حال سر خوردن به پرتگاهی خطرناک هستند. این متخصصان میگویند آثار منفی استفاده از چتباتهای هوش مصنوعی در حوزه سلامت روان به طور فزایندهای دیده میشود؛ از جمله ایجاد وابستگی عاطفی، تشدید علائم اضطراب، خودتشخیص، و تقویت الگوهای فکری توهمآمیز، افکار تاریک و تمایلات خودکشی.

دکتر لیسا موریسون کولتارد، مدیر استانداردهای حرفهای، سیاست و تحقیقات در انجمن بریتانیایی مشاوره و رواندرمانی، اعلام کرد که دو سوم اعضای این انجمن در یک نظرسنجی اخیر نگرانی خود را درباره «درمان با هوش مصنوعی» ابراز کردهاند. کولتارد گفت: «بدون درک و نظارت مناسب بر درمان با هوش مصنوعی، ممکن است در حال سر خوردن به پرتگاهی خطرناک باشیم که در آن برخی از مهمترین عناصر درمان از دست میروند و افراد آسیبپذیر از لحاظ ایمنی در تاریکی قرار میگیرند. ما نگرانیم که اگرچه برخی ممکن است مشاوره مفیدی دریافت کنند، دیگران ممکن است اطلاعات گمراهکننده یا نادرست درباره سلامت روان خود دریافت کنند که پیامدهای بالقوه خطرناکی دارد. مهم است بدانیم که درمان فقط دادن مشاوره نیست، بلکه ایجاد فضای امنی است که فرد احساس کند شنیده میشود.»

دکتر پال برادلی، مشاور متخصص در حوزه انفورماتیک برای کالج سلطنتی روانپزشکان، تاکید کرد که چتباتهای هوش مصنوعی «جایگزینی برای مراقبت حرفهای از سلامت روان یا رابطه حیاتی که پزشکان با بیماران برای حمایت از بهبودی ایجاد میکنند، نیستند». او افزود برای ابزارهای دیجیتال که مکمل مراقبتهای بالینی هستند، نیاز به تضمینهای مناسب وجود دارد و همه افراد باید بتوانند به خدمات درمانی ارائهشده توسط متخصص سلامت روان دسترسی داشته باشند.

برادلی گفت: «متخصصان دارای آموزش، نظارت و فرآیندهای مدیریت ریسک هستند که تضمین میکنند مراقبت مؤثر و ایمن ارائه دهند. تاکنون، فناوریهای دیجیتال آزاد که خارج از خدمات موجود سلامت روان استفاده میشوند، ارزیابی نشده و به استانداردهای مشابه پایبند نیستند.»

نشانههایی وجود دارد که شرکتها و سیاستگذاران شروع به واکنش کردهاند. این هفته، شرکت اوپن ای آی، سازنده چت جی پی تی، اعلام کرد قصد دارد نحوه پاسخگویی به کاربران در معرض فشار عاطفی را تغییر دهد، پس از اقدام قانونی خانواده نوجوانی که پس از ماهها مکالمه با چتبات خودکشی کرد. پیشتر در ماه گذشته، ایالت ایلینوی آمریکا اولین دولت محلی شد که استفاده از چتباتهای هوش مصنوعی به عنوان درمانگر مستقل را ممنوع اعلام کرد.

این اقدامات پس از شواهدی از آسیبهای سلامت روان انجام شد. یک مطالعه در تیر گزارش داد هوش مصنوعی میتواند محتوای توهمآمیز یا بزرگنمایانه را در تعامل با کاربران آسیبپذیر نسبت به روانپریشی تقویت کند. یکی از نویسندگان گزارش، همیلتون مورین از موسسه روانپزشکی کالج کینگز لندن، گفت استفاده از چتباتها برای حمایت از سلامت روان «به شدت رایج» است.

تحقیقات او با مشاهده افرادی که در دوران افزایش استفاده از چتباتها به بیماری روانپریشی مبتلا شدند، آغاز شد. او افزود که چتباتها درمان مؤثر اضطراب موسوم به «قرارگیری در معرض و پیشگیری پاسخ» را تضعیف میکنند، درمانی که نیازمند رویارویی با موقعیتهای ترسناک و اجتناب نکردن از رفتارهای ایمنی است. دسترسی ۲۴ ساعته به چتباتها باعث «کمبود مرزها» و «خطر وابستگی عاطفی» میشود. چت باتها در کوتاهمدت اضطراب را کاهش میدهد اما در واقع چرخه را ادامه میدهد.

مت هاسی، رواندرمانگر معتبر BACP، مشاهده کرده است افراد از چتباتها به طرق مختلف استفاده میکنند، حتی برخی نسخه مکالمات را به جلسات میآورند تا به او نشان دهند که اشتباه کرده است. وی توضیح داد که افراد برای خودتشخیصی شرایطی مانند اختلال بیشفعالی- نقص توجه یا اختلال شخصیت مرزی از چتباتها استفاده میکنند که میتواند «به سرعت نحوه دید فرد به خود و انتظارات او از دیگران را شکل دهد، حتی اگر نادرست باشد».

هاسی افزود: «هوش مصنوعی چون طراحی شده تا مثبت و تأییدکننده باشد، به ندرت سوال بد فرم یا فرض نادرست را به چالش میکشد. در عوض، باور اولیه کاربر را تقویت میکند، و او پس از مکالمه احساس میکند حق با اوست. این ممکن است لحظهای خوشایند باشد اما میتواند سوءتفاهمها را تثبیت کند.»

کریستوفر رولز، رواندرمانگر معتبر UKCP، گفت با وجود اینکه نمیتواند اطلاعات مراجعان خود را فاش کند، شاهد «تجربیات منفی» بوده است، از جمله مکالماتی که حداقل نامناسب و در بدترین حالت خطرناک بودهاند. او نگران مراجعان ۲۰ سالهای است که از چتباتها به عنوان «درمانگر جیبی» استفاده میکنند: «آنها اگر در مورد مسائل روزمره مانند خرید قهوه یا انتخاب رشته در دانشگاه مشورت نکنند، مضطرب میشوند.»

رولز افزود: «ریسک اصلی شامل وابستگی، تنهایی و افسردگی است که روابط طولانیمدت آنلاین میتواند ایجاد کند.» او از افرادی آگاه است که افکار تاریک خود را با چتباتها در میان گذاشتهاند و پاسخهایی مرتبط با خودکشی و مرگ کمکی دریافت کردهاند. او در پایان گفت: «اساساً این وضعیت مانند غرب وحشی است و من فکر میکنم ما درست در آستانه مشاهده تأثیرات کامل چتباتهای هوش مصنوعی بر سلامت روان قرار داریم.»